Ionuț-Eugen Ioniță ■

Gâlceava platformelor, pentru linkurile noastre

Am observat în ultimul an un lucru simplu: tot mai des, căutarea nu mai arată ca o listă de linkuri, ci ca un “răspuns” gata scris. Îți apare un rezumat în partea de sus, îți spune ce crede sistemul că vrei să afli, și… tentația e să închizi pagina. Ai economisit timp. Dar ai pierdut ceva: drumul până la sursă.

De aici pornește și disputa care fierbe acum în Marea Britanie și se va simți peste tot: cine are voie să folosească articolele și site-urile altora ca să genereze rezumate cu AI? Și, dacă un site spune “nu vreau să fiu folosit pentru rezumate”, are voie Google să-l “pedepsească” cu invizibilitate?

Google avertizează public că, dacă regulatorii forțează o separare prea dură între “căutarea clasică” și “căutarea cu AI”, s-ar putea “rupe” experiența Search, adică să devină mai fragmentată pentru utilizatori.

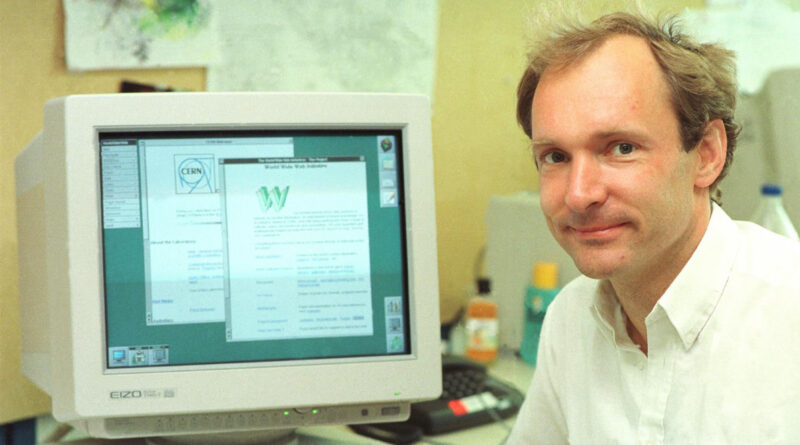

În același timp, Tim Berners-Lee, omul care a inventat World Wide Web, spune că suntem într-o “bătălie pentru sufletul internetului” și că încă se poate repara direcția în care am luat-o.

Cum am ajuns de la “web pentru toți” la “web pentru câțiva”

La început, web-ul era gândit ca o bibliotecă deschisă: oricine putea publica, oricine putea citi, iar legăturile dintre pagini (linkurile) erau “metroul” care te ducea rapid dintr-un loc în altul.

Tim Berners-Lee. Credit: CERN

Berners-Lee spune că unul dintre primele momente în care lucrurile au luat-o pe alt drum a fost când o piesă esențială a internetului – sistemul de nume (domeniile, gen “site.ro”) – a devenit treptat o zonă comercială, nu una gestionată strict în interes public.

Apoi au apărut platformele uriașe și mecanismele care ne țin lipiți de ecrane: algoritmi care promovează ce stârnește reacții puternice, nu neapărat ce e corect sau util.

În limbaj simplu: dacă internetul era inițial un oraș cu străzi publice, acum multe “intersecții” importante sunt controlate de câteva companii. Iar când se schimbă regulile la intersecții, se schimbă tot traficul.

Ce se întâmplă acum: un “buton de refuz” pentru AI, fără să dispari din Google

Ce sunt “AI Overviews”, pe românește?

Sunt acele rezumate generate automat care apar deasupra rezultatelor. În loc să citești un articol, primești o sinteză. Problema publisherilor (site-uri de știri, bloguri, publicații) e simplă: dacă utilizatorul nu mai intră pe site, scad traficul și veniturile din reclame sau abonamente.

Ce propune autoritatea britanică (CMA)?

Autoritatea britanică de concurență (CMA) a propus ca publisherii să poată refuza folosirea conținutului lor în rezumatele AI, fără să fie scoși și din căutarea clasică. Pentru că, în unele situații, “refuzul” poate însemna azi și “dispariția” din Search.

Consultarea publică are termen până pe 25 februarie 2026, deci discuția e în plină desfășurare.

De ce spune Google că “se poate strica” Search?

Google susține că AI-ul nu e un accesoriu nou lipit peste căutare, ci e folosit “în interior” de mult timp ca să decidă ce rezultate sunt relevante. Dacă îl separi cu forța, riști să creezi o experiență ciudată: unele site-uri apar într-un loc, altele în alt loc, unele răspunsuri sunt incomplete, iar utilizatorul nu mai știe ce vede.

Totuși, Google spune că lucrează la mecanisme prin care site-urile să poată opta să nu fie folosite în funcțiile generative, dar să rămână indexate pentru căutarea obișnuită.

Unde intră Cloudflare și de ce contează?

Cloudflare e, pe scurt, o companie care “ține în picioare” o parte mare din internet (securitate, protecție, livrare rapidă de conținut). CEO-ul Cloudflare spune că nu e suficient un simplu buton de opt-out: ar trebui o separare clară între “roboții care scanează web-ul pentru căutare” și “roboții care scanează web-ul ca să hrănească AI-ul”, ca să fie competiția mai corectă.

Inovații recente: “roboții care citesc site-uri” pot fi opriți, iar datele pot rămâne la tine

Aici e partea interesantă: disputa nu e doar politică. E și tehnică.

1) Blocarea “roboților” AI (crawleri), dintr-un click

Pe internet există programe automate (“roboți”) care intră pe pagini și le citesc. Unele sunt legitime (de exemplu, indexarea pentru căutare). Altele sunt folosite ca să strângă conținut pentru modele AI.

Cloudflare a introdus o opțiune simplă: un comutator prin care poți bloca roboții AI cunoscuți.

Mai mult, Cloudflare a promovat și ideea că accesul AI la conținut ar trebui condiționat de compensare, nu luat “pe gratis”.

2) “Seiful” de date: ce propune Berners-Lee prin Solid

Berners-Lee susține o idee pe care o înțelege oricine: datele tale (despre tine, obiceiuri, preferințe) sunt împrăștiate în multe locuri. El promovează Solid – un model în care ai un fel de “seif” (pod) de date controlat de tine, iar tu decizi cui dai acces și cât.

Avantaje, dezavantaje și provocări: cine câștigă, cine pierde

Avantaje

- Pentru utilizatori: rezumatele AI pot economisi timp, mai ales la întrebări simple (program, definiții, pași tehnici).

- Pentru publisheri: un opt-out real ar însemna negociere mai corectă și șanse mai mari să-și protejeze munca.

- Pentru piață: reguli clare pot reduce situațiile în care o singură companie controlează și poarta (căutarea), și rezumatul (AI), și banii (publicitatea).

Dezavantaje

- Risc de “internet cu bariere”: dacă tot mai multe site-uri blochează roboții, unele răspunsuri pot deveni mai slabe sau mai incomplete.

- Confuzie pentru public: un rezumat “sună” credibil chiar și când e greșit. Iar dacă nu vezi sursa, îți e mai greu să verifici.

Provocări (cele care vor decide rezultatul)

- Cum definim “folosire corectă”? E suficient să pui un link? Trebuie acord și plată? Cine stabilește asta?

- Cum separi corect roboții? În practică, “roboții” se pot deghiza, pot încălca reguli. Controlul real e greu și costisitor.

- Încrederea publică: Berners-Lee avertizează că web-ul a fost “optimizat” pentru comportamente toxice și cere soluții care pun omul în centru, nu doar profitul.

Impactul asupra industriei și asupra oamenilor obișnuiți

Pentru industrie, miza e uriașă: dacă modelul “Google trimite trafic, site-ul trăiește din trafic” se rupe, multe publicații vor simți presiune financiară.

Pentru utilizatori, miza e mai puțin vizibilă, dar mai importantă civic: dacă ne obișnuim să consumăm doar rezumate, ajungem să citim mai puțin context, să verificăm mai rar, și să fim mai ușor de păcălit de conținut “bine scris, dar fals”.

Un mic test practic, pe care îl recomand oricui:

- caută subiectul în două locuri diferite;

- verifică data și sursa;

- dacă vezi un rezumat AI, deschide măcar un link din el – ca să vezi dacă rezumatul chiar respectă textul original.

Care este concluzia?

Ce mi se pare sănătos în toată povestea asta e că, în sfârșit, discuția nu mai e “AI e bun / AI e rău”. Discuția devine: cine controlează accesul la informație și cine plătește pentru munca din spatele informației.

Google cere să nu fie tăiat “cu toporul” un sistem care, spune compania, e deja construit în jurul AI-ului.

CMA încearcă să pună frână unei situații în care publisherii nu au opțiuni reale.

Iar Berners-Lee vine cu o busolă morală: web-ul poate fi reparat dacă punem din nou controlul, colaborarea și compasiunea în centrul lui.

Nota optimistă? Suntem încă într-un moment în care regulile se scriu. Dacă ele vor fi clare și corecte, AI-ul poate rămâne un ajutor (rapiditate, acces), fără să devină un aspirator care golește web-ul de conținut și încredere. Iar asta ar fi, până la urmă, cea mai bună veste pentru toți: pentru utilizatori, pentru presă și pentru viitorul internetului.

Surse și context (pentru lectură suplimentară)

- The Guardian – ‘It’s not too late to fix it’: web inventor Tim Berners-Lee says he is in a ‘battle for the soul’ of the internet

- Business Insider – Google warns against ‘breaking Search,’ as pressure mounts over web future

- Reuters – UK pushes Google to allow sites to opt out of AI overviews